Destacados

Las Profecías Inquietantes de Juan XXIII [y los intrigantes misterios de su vida]

Cómo le surgieron esas profecías y cómo se relacionan con su intrigante vida. ¿Conoces…

Cómo Prepararte para los 3 Dolores que Pronto Sacudirán al Mundo

Revelación a la monja nordestina sobre las severas consecuencias que tendrán para los incrédulos….

¡El Despertar de la Iglesia! Cómo sucederá el Triunfo de Dios en la Batalla actual Contra el Mal

La batalla invisible que dará el triunfo a Dios en el Final de los…

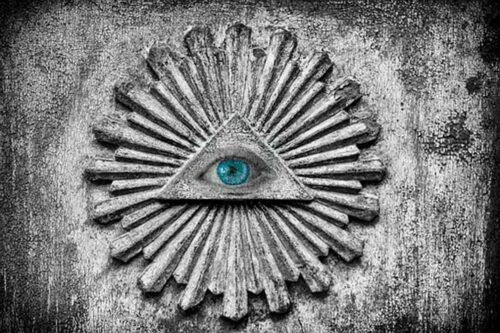

¡Al Descubierto! El Plan Masónico para Convertir al Catolicismo en la Religión del Nuevo Orden

Cómo pretenden cambiar el catolicismo para que sea la religión del Nuevo Orden Mundial….

La devastadora Peste que Vendrá Antes del Aviso y cómo Curarla [revelación al Diácono John Martínez]

Cómo será la peste, quienes la sufrirán, quienes podrán curarse y cómo. El Libro…

¡No tengas miedo! Los 3 Secretos Revelados a María Julia Jahenny para Protección en la Tribulación

Jesús y María entregaron tres sacramentales a María Julia Jahenny para protección durante la…

Noticias

El regreso de la Brujería está Devastando el Mundo que creó Dios

Los rituales ahora se hacen públicamente para cambiar la moral del mundo. Nuestra sociedad…

Cómo se Desarrolló el Carisma del Mayor Sanador del siglo XX [por Gracia de Dios]

El impresionante testimonio del Ministerio de Sanación del Padre Emiliano Tardif …

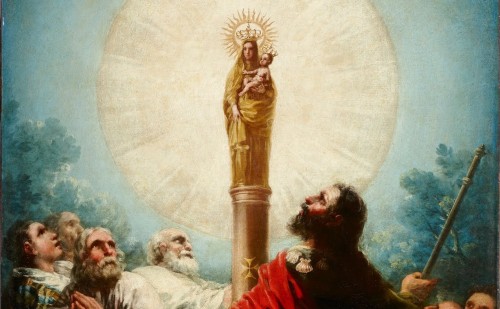

María se Aparece [en vida] al Apóstol Santiago en España

Cuando la Virgen María aún estaba viva, se produjo su primera aparición a Santiago, que evangelizaba España…

Reveladores Testimonios de Exorcistas sobre su Lucha Contra el Demonio

Lecciones y consejos de exorcistas que están en la primera línea de fuego…

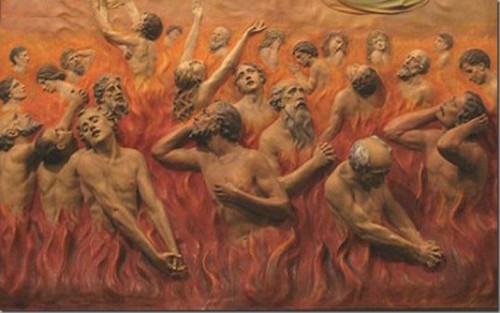

5 Errores Fatales por Desestimar la Existencia del Infierno

Las consecuencias negativas para las personas y las sociedades cuando se omite predicar sobre el infierno…

Cómo puedes Ayudar las Almas del Purgatorio y como Te pueden Ayudar a Ti

Esta información es vital para ti y para las pobres almas del purgatorio, te lamentarás si no lo lees…

![Las Profecías Inquietantes de Juan XXIII [y los intrigantes misterios de su vida]](https://forosdelavirgen.org/wp-content/uploads/2024/04/13-4-juan-xxiii-500x353.jpg)

![La devastadora Peste que Vendrá Antes del Aviso y cómo Curarla [revelación al Diácono John Martínez]](https://forosdelavirgen.org/wp-content/uploads/2024/04/12-4-medicos-con-escafandra-500x333.jpg)